摘要:本文分享了深度学习模型调参的经验,重点介绍了RNN(循环神经网络)和CNN(卷积神经网络)的优化之旅。通过调整模型参数,可以显著提高模型的性能和准确性。文章提供了实用的调参技巧和建议,帮助读者更好地理解和应用深度学习模型,从而在实际应用中取得更好的效果。

本文目录导读:

随着深度学习的飞速发展,神经网络模型如循环神经网络(RNN)和卷积神经网络(CNN)在许多领域取得了显著成果,训练这些模型并非易事,因为它们的性能在很大程度上取决于参数的设置,本文将分享我在使用RNN和CNN过程中的调参经验,希望能为其他研究者提供一些有价值的参考。

数据准备与预处理

在深度学习模型训练之前,数据准备和预处理至关重要,对于RNN和CNN模型,我们需要确保输入数据的格式和结构适合模型的训练,以下是我的一些经验:

1、数据清洗:去除噪声、缺失值和异常值,确保数据的准确性。

2、数据标准化:将输入数据缩放到同一尺度,有助于模型更快地收敛。

3、数据增强:通过旋转、裁剪、翻转等方式增加数据多样性,提高模型的泛化能力。

模型选择与结构设计

选择合适的模型结构和参数是深度学习成功的关键,对于RNN和CNN,我们需要根据具体任务选择合适的网络结构,以下是我的一些经验:

1、RNN模型选择:根据任务需求选择适合的RNN模型,如LSTM、GRU等,对于序列建模和预测任务,LSTM通常具有较好的性能。

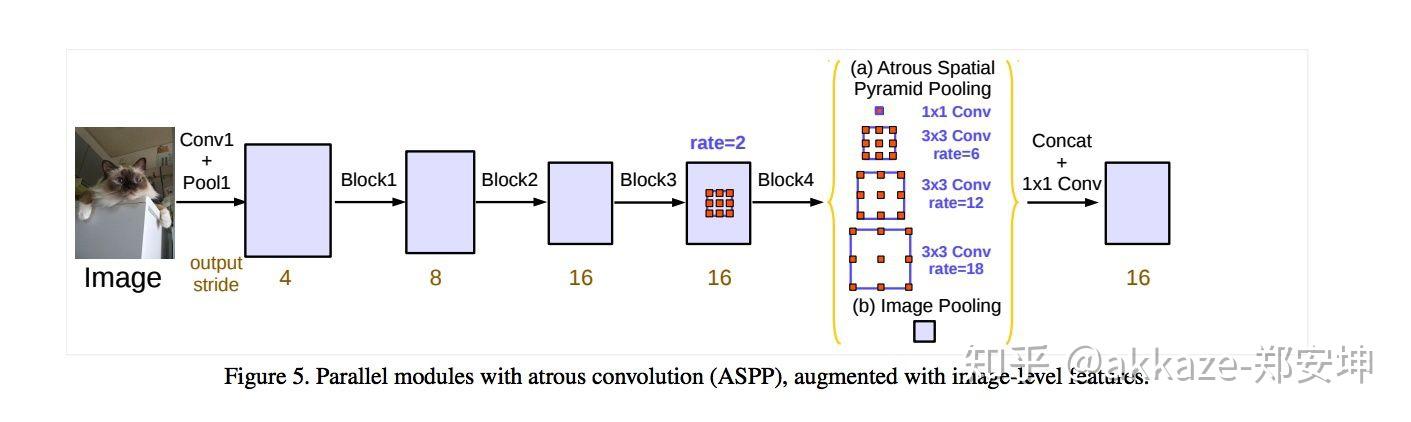

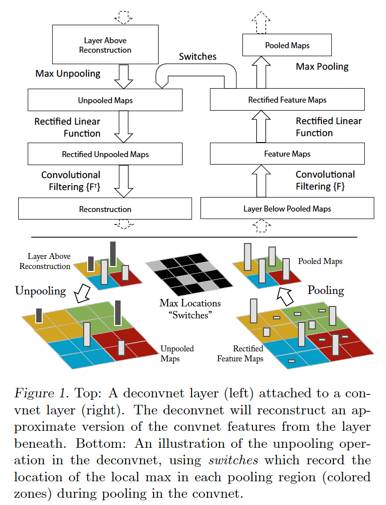

2、CNN模型选择:根据输入数据的维度和特征选择适合的CNN模型,对于图像分类任务,可以使用经典的卷积层+池化层的结构。

3、网络深度与宽度:根据任务复杂度和数据量调整网络深度和宽度,更深的网络可以提取更高级的特征,但也可能导致过拟合。

调参策略与技巧

在训练过程中,调整参数是提高模型性能的关键步骤,以下是我的一些经验:

1、学习率调整:学习率是影响模型训练效果的重要因素,过小的学习率可能导致模型收敛缓慢,过大的学习率可能导致模型发散,我们需要根据模型的训练情况动态调整学习率。

2、批量大小选择:批量大小影响模型的训练速度和性能,选择合适的批量大小可以在保证训练速度的同时,提高模型的性能。

3、正则化与优化器选择:使用适当的正则化方法(如L1、L2正则化)和选择合适的优化器(如SGD、Adam等)有助于防止过拟合,提高模型的泛化能力。

4、损失函数选择:根据任务需求选择合适的损失函数,对于分类任务,通常使用交叉熵损失;对于回归任务,通常使用均方误差损失。

5、早期停止法:在验证误差达到一定程度时停止训练,防止过拟合。

6、模型融合:通过集成学习等方法融合多个模型的预测结果,提高模型的性能。

实验与验证

在调参过程中,实验与验证是非常重要的环节,以下是我的一些经验:

1、交叉验证:通过交叉验证评估模型的性能,确保模型的稳定性和泛化能力。

2、记录实验过程:详细记录实验过程、参数设置和结果,方便后续分析和比较。

3、对比实验:与不同模型、不同参数设置进行对比实验,找出最佳模型和参数组合。

本文分享了我在使用RNN和CNN过程中的调参经验,深度学习领域还有许多值得探索的问题和挑战,我将继续深入研究深度学习模型调参技术,探索更有效的调参方法和策略,为深度学习的发展做出贡献。

参考文献

[此处插入参考文献]

附录

[此处可附上调参过程中使用的代码、表格、图表等辅助材料]

深度学习模型的调参是一个复杂而重要的过程,通过本文的分享,希望能为其他研究者提供一些有价值的参考和经验,在实际应用中,我们需要根据具体任务和数据情况灵活调整模型和参数,不断尝试和优化,以达到最佳的性能。

粤ICP备19126298号

粤ICP备19126298号